Sa., 23.05.20 | 16:00 Uhr

Das Erste

Gesichtserkennung: Ich sehe, was du fühlst!

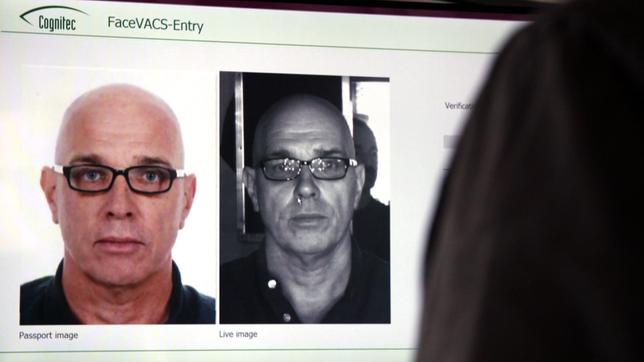

Wer von einem der sieben deutschen Großflughäfen abfliegt, hat mit dem System schon Bekanntschaft gemacht: "eGates", die mit "EasyPASS" ausgerüstet sind und durch die Passagiere mit ihrem biometrischen Reisepass schnell durch die Kontrolle kommen können. In den Kontrollkabinen wird der Reisepass auf einen Dokumentenleser gelegt, das Gesichtsbild des Reisenden mit einer Kamera aufgenommen und mit einer Gesichtserkennungssoftware überprüft, ob die Personen mit den in den Pässen gespeicherten Lichtbildern übereinstimmen. Die Technik dahinter kommt von Cognitec – einer führenden Firma in der Künstlichen Intelligenz-gestützten Gesichtserkennung. Ob in "E-Gates" an Flughäfen, bei der Grenzkontrolle oder der Videoüberwachung durch Sicherheitsbehörden – die Software ist Made in Dresden. "Die Software schaut sich zuerst die Festpunkte im Gesicht an: Augenabstand, Abstand Nase – Mundwinkel zum Beispiel", erklärt Unternehmenssprecherin Elke Oberg, "und dann noch die Beschaffenheit, die Oberflächenbeschaffenheit des Gesichts, also die Hügel und Täler sozusagen, und aus diesen ganzen Daten kann man dann also für jedes Gesicht ganz individuell einen Datensatz erstellen."

Dieses digitale, dreidimensionale Muster macht uns unverwechselbar, aber nur mit unserem echten Gesicht. Mit einem Foto funktioniert das nicht, die Software meldet sofort: "Überprüfung fehlgeschlagen!" Diese Anwendung automatisierter Gesichtserkennung ist mittlerweile etabliert, wird von Passagieren an Flughäfen rege genutzt, kaum noch hinterfragt. Anders ist die Situation bei der ähnlichen Technik der Video-Gesichtserkennung, wie sie etwa in China mittlerweile Standard ist.

China: Kameras überall?

Geschätzt 600 Millionen Kameras nehmen in China die Menschen ins Visier, auf den Straßen und Plätzen, in Unternehmen, Einkaufszentren und an Bankautomaten. Der BBC-Chinakorrespondent John Sudworth probierte das System Ende 2017 in einem Experiment aus. Die Pekinger Polizei machte ein Foto von ihm. Er versuchte daraufhin, in der chinesischen Stadt unterzutauchen und nicht von Kameras erkannt zu werden, um zu testen, wie gut das System funktioniert. Es dauerte nur sieben Minuten, bis das Überwachungssystem den Journalisten aufspürte.

Die Gesichtserkennungstechnik von heute lässt sich nicht mehr austricksen. Selbst unvollständig gefilmte oder absichtlich verdeckte Gesichter erkennt die Software, gleicht sie mit existierenden Fotos aus Datenbanken ab und zeigt einen Treffer an. Niemand im System bleibt damit unentdeckt. "Die letzten fünf Jahre werden in unsere Industrie als 'Gesichtserkennungsrevolution' bezeichnet“, erklärt Elke Oberg von Cognitec, "weil, sich die Genauigkeitsraten so stark verbessert haben, dass man jetzt diese Systeme auch sehr, sehr zuverlässig einsetzen kann. Das liegt vor allem an neuronalen Netzen, an neuen Methoden, wie die Algorithmen diese Entscheidungen treffen, es liegt auch an neuen Trainingsmethoden und die Computer werden natürlich auch immer besser."

Berlin Südkreuz – Versuch automatisierte Gesichtserkennung

Immer besser? 2017 startete am Berliner Bahnhof Südkreuz ein groß angelegter Versuch in Sachen "automatisierte Gesichtserkennung". Die Bundespolizei und die Deutsche Bahn testeten die Systeme dreier Hersteller, die versuchten, Personen auf einer Rolltreppe, in der Bahnhofshalle und am Eingang zu identifizieren. In der ersten Phase arbeiteten die Systeme mit 312 freiwilligen Probanden und eigens angefertigten, gut ausgeleuchteten Fotos, die in einer Datenbank hinterlegt wurden. In der zweiten Phase wurden mehrere Fotos von 201 Probanden direkt aus dem Videostream genommen. Zur Erkennung durch drei von insgesamt 77 Kameras am Bahnhof Südkreuz mussten die Probanden einen Bluetooth-Transponder mit sich führen, damit unabhängig von der Erkennungsleistung ihre Anwesenheit aufgezeichnet werden konnte.

Die Bundespolizeidirektion hat nun den Abschlussbericht zum zweiphasigen Test der Gesichtserkennung am Sicherheitsbahnhof Südkreuz in Berlin veröffentlicht. In der ersten Phase wurden ungefähr 61.000 Gesichter analysiert und eine durchschnittliche Erkennungsleistung von 68,5 Prozent erzielt, in der zweiten, "realistischeren" Phase waren es rund 41.000 Gesichter, wobei die durchschnittliche Trefferrate auf 82,8 Prozent anstieg. Dementsprechend spricht der Abschlussbericht von einem wirksamen Unterstützungsinstrument, "das ein wesentlicher Beitrag zur Bahnsicherheit" sein kann.

Bei der im zweiten Fall erzielten Trefferrate des "logischen Gesamtsystems" wurde bewusst auf Verbesserungen verzichtet, etwa der Änderung der Beleuchtung. Also seien "direkt aus Video-Überwachungsanlagen gewonnene Fotos tauglich für die biometrische Fahndung". In dem Bericht wird betont, dass weitere Verbesserungen möglich seien: "Biometrische Gesichtserkennung könnte hier unter Berücksichtigung einer (max.) Trefferrate von bis zu 94,4 Prozent im Rahmen der Testphase 1 beziehungsweise bis zu 98,1 Prozent im Rahmen der Testphase 2 des Teilprojektes 1 "Biometrische Gesichtserkennung" wertvolle Unterstützung bei der Früherkennung von Anschlägen beziehungsweise bei der Fahndung nach Anschlägen von Terroristinnen und Terroristen aus dem islamistischen Spektrum leisten.

In einer eigens zum Abschlussbericht verfassten Stellungnahme von Innenminister Seehofer heißt es, dass mit der intelligenten Videoanalyse eine effizientere und effektivere Polizeiarbeit möglich ist. "Die Ergebnisse zeigen“, so ist zu lesen, "dass die Technik zur Gesichtserkennung unsere Polizistinnen und Polizisten im Alltag erheblich unterstützen kann. Die Systeme haben sich in beeindruckender Weise bewährt, so dass eine breite Einführung möglich ist."

Gesichtserkennung: drohender Verlust von Freiheit?

Das Thema Gesichtserkennung steht für eine grundsätzliche Auseinandersetzung mit Zukunftstechnologien. Die Technik verspricht mehr Sicherheit, Effizienz und das Potenzial für neue Produkte. Gleichzeitig besteht durch den Einsatz der Technik die Gefahr eines massiven Eingriffs in die persönlichen Freiheiten. Markus Beckedahl ist netzpolitischer Aktivist, Journalist und Chefredakteur des von ihm 2002 gegründeten Blogs "netzpolitik.org", in dem alle Themen der Informationsgesellschaft behandelt werden. Er sieht vor allem die gesellschaftliche Herausforderung, dass sich viele Menschen nicht mit technologischen Entwicklungen auseinandersetzen wollen und da Überwachung in der Regel ziemlich intransparent abläuft, heißt das für Markus Beckedahl: "Uns ist nicht wirklich bewusst, was da abläuft und das ist natürlich eine gefährliche Entwicklung, denn das führt dann auch zu mehr Überwachung, weil weniger Widerstand dagegen in der Gesellschaft vorhanden ist."

Er hält es auch für einen Mythos, dass automatisierte Gesichtserkennungssysteme zu mehr Sicherheit führen, weil es keine wissenschaftlichen Belege dafür gebe, dass mehr Überwachung auch tatsächlich zu mehr Sicherheit führt. "Es geht hier um ein subjektives Sicherheitsgefühl", sagt Beckedahl, "und das ist eine sehr gefährliche Entwicklung, wenn wir uns die ganze Zeit von Gefühlen leiten lassen und den Kopf ausschalten." Die technologische Entwicklung, so sieht es der Journalist, sorgt dabei einerseits für mehr Begehrlichkeiten auf Seiten von Politik und Sicherheitsbehörden, andererseits gäbe es keine entsprechende Debatte darüber, was automatisierte Überwachung mit unserer Gesellschaft macht und ob wir das überhaupt wollen.

Wenn wir uns als Gesellschaft dieser grundsätzlichen Frage nicht stellen, so befürchtet Markus Beckedahl, wird das zum Beispiel dazu führen, dass weniger Menschen sich trauen werden, auf Demonstrationen zu gehen und ihre freie Meinungsäußerung im öffentlichen Raum zu praktizieren. Mit Folgen: "Wir werden uns konformer verhalten, wir werden uns aber auch unfreier verhalten", sagt er, "weil wir die ganze Zeit im Hinterkopf mitschwingen haben: Wir werden gerade beobachtet, bitte lächeln, diese Fotos könnten einmal gegen dich verwendet werden. Das ist eine Welt, die langsam schon in China Realität wird, und wo ich hoffe, dass wir in Deutschland niemals in einer solchen Welt leben werden."

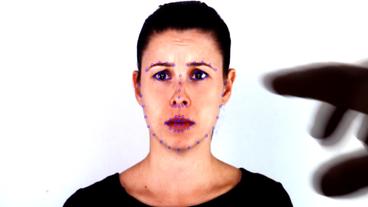

Automatisierte Emotionserkennung: Ich sage Dir, wie Du fühlst

Dabei geht die Forschung sogar noch weiter: "Automatisierte Gesichtserkennung" heißt heute nicht nur "Ich weiß, wer Du bist", sondern auch, "Ich weiß, wie Du fühlst". Das jedenfalls ist erklärtes Ziel einer Software, die von Wissenschaftlern des Fraunhofer-Instituts für integrierte Schaltungen IIS in Erlangen entwickelt wurde. "Es sind verschiedene Aspekte im Gesicht, die Emotionen ausmachen", sagt Dr. Jens-Uwe Garbas, Leiter des Projekts. "Bewegungen von Gesichtsmuskeln, die dann Freude, Ärger, Trauer und so weiter ausdrücken." Das wird in den meisten Kulturkreisen verstanden. Und das, was ich als Mensch sehen kann im Gesichtsausdruck eines anderen, das können wir Software auch beibringen und das mit einer sehr, sehr hohen Trefferrate." Aber, so betont Jens-Uwe Garbas deutlich: "Was wir nicht machen können, ist hinter die Fassade blicken und wirklich herauszufinden, was hat jemand gedacht oder hat jemand nur etwas vorgespielt."

Daher sind für ihn auch die Ängste, die möglicherweise mit der Idee einer "Emotionserkennung" verbunden sind, nicht berechtigt. "Mit Mimikanalyse, mit Gesichtsanalyse können sie nur das erkennen, was sie sehen", erklärt Garbas, "und da hat man oft den Fall, dass an Bahnhöfen, Flughäfen, die Leute natürlich aufgeregt, gestresst sind und deswegen gar nicht so entspannt wirken. Daraus jetzt zu schließen, dass diese Person deswegen aufgeregt ist, weil sie vielleicht ein Attentat vorhat, das wäre grundfalsch. Wir sind alle nervös, wenn wir reisen."

Für die Entwicklung ihrer Software SHORE haben die Erlanger Forscher 22 Schauspieler und Schauspielerinnen alle denkbaren Emotionen durchspielen lassen und dabei gefilmt, um genau zu erfassen, welche Muskelbewegungen und welche Kombinationen verschiedener Bewegungen welche Emotion ausdrücken. Damit trainieren sie die Algorithmen ihres Systems. "Wir sind jetzt soweit, dass wir auch sehr subtile Reaktionen erkennen können", erklärt Jens-Uwe Garbas, "die sogenannte emotionale Valenz, also ob eine Person offensichtlich etwas positiv oder negativ bewertet und das auch sehr sensibel und sensitiv, das heißt wir reagieren auf sehr feine mimische Reaktionen." Doch wofür das Ganze? Was sind Anwendungsfelder für "automatisierte Emotionserkennung"?

"Eine typische Anwendung für Emotionserkennung ist Interaktion zwischen Menschen und Maschinen", sagt Garbas. "Wir bringen etwa einem Roboter bei, mit autistisch veranlagten Kindern zu trainieren, soziale Signale, Gesichtsausdrücke besser zu verstehen. Diese haben da oft Schwierigkeiten, Mimik zu interpretieren, zu deuten und die lernen das in so einem spielerischen Umgang mit diesem Roboter, der auch die Emotionen der Kinder dann erkennt. Dann haben wir auch Anwendungen im Bereich Automobil, sogenannte Fahrerzustandserkennung oder Insassenzustandserkennung. Da geht es darum, den emotionalen Zustand von Insassen zu erkennen Erkennung von Ablenkung, von Stresszuständen oder von Überforderung."

Emotionserkennung: Zwischen Sinnhaftigkeit und Unbehagen

Doch ungeachtet solcher Anwendungen, deren Sinnhaftigkeit für viele Menschen noch nachvollziehbar sein dürfte, entsteht durch die technologische Entwicklung ein Markt für Anwendungen, die eher für Unbehagen sorgen dürften. Die neuen, lernfähigen Algorithmen sind etwa auch in der Lage, den Gemütszustand von Kunden in Geschäften oder Supermärkten zu erkennen, diese Daten mit dem bisherigen Kaufverhalten zu verknüpfen und diese Erkenntnisse wiederum für personalisierte Werbung oder individuelle Angebote zu nutzen.

Im Sommer 2017 ließ eine deutsche Supermarktkette auf diese Weise die Gesichter von Kunden analysieren, die Bildschirme mit Werbung im Kassenbereich anschauten. Die Kameras analysierten Geschlecht und Alter und die Dauer der Betrachtung. Das Unternehmen nutzte nach eigener Aussage die entstandenen Daten nicht, sondern übermittelte sie an eine Firma, die damit nach eigener Aussage "die Qualität der ausgestrahlten Werbefilme zielgruppenorientiert anpassen wollte." Nach großem Protest von Kunden und Datenschützern wurde das Projekt abgebrochen.

Für Jens-Uwe Garbas sind solche Erfahrungen jedoch kein Grund, die Entwicklungsrichtung in Sachen "Emotionserkennung" zu ändern: "Solche Technologien bieten natürlich das Potenzial, Leute zu beobachten und auch zu manipulieren und gerade deswegen ist es auch wichtig, sich aktiv mit dieser Technologie und den Folgen von solchen Technologien auseinanderzusetzen. Wir können das nur tun, wenn wir diese Technologien auch selbst in der Hand haben und selbst verstehen, was damit möglich ist und was damit nicht möglich ist."

Einen Einsatz bei der Überwachung im öffentlichen Raum, wie bei der Gesichtserkennung, lehnt Jens-Uwe Garbas vom Fraunhofer IIS in jedem Fall kategorisch ab. "Im Bereich Überwachung sind wir gar nicht aktiv, weil wir diese Art der Anwendung auch als gefährlich und kritisch ansehen. Man hat bei der Emotionserkennung, wie bei anderen Verfahren des maschinellen Lernens, immer eine gewisse Wahrscheinlichkeit für ein Ergebnis, man kann aber auch falsch liegen. Wenn ich aber eine gewissen Wahrscheinlichkeit habe, Dinge falsch zu erkennen, dann möchte ich daraus keine hoheitsrechtlichen Handlungen ableiten."

Autor: Thomas Hillebrandt (SWR)

Stand: 09.04.2021 03:03 Uhr